Os almanaques eram publicações anuais que traziam de tudo, das fases da lua até remédio para unha encravada. Isto aqui é uma versão em pílulas semanais. Nesta edição: inteligência artificial e superficial, videotas e magnatas, cópias e originais, ficção e realidade, produtos suspeitos e mercados desconfiados, e a guerra d’água.

No filme Muito Além do Jardim (Hal Ashby, 1979), baseado no romance O Videota de Jerzy Kosinski, Chance (Peter Sellers) é um jardineiro numa mansão que aprendeu tudo sobre o mundo lá fora pela televisão. Após uma série de acasos, acaba adotado por um conselheiro do presidente dos EUA. Todos se encantam por aquele homem bem-apessoado que fala coisas profundas, na verdade, frases feitas que ele ouvira em diálogos televisivos ou de seu trabalho com as plantas. Passa a ser tomado por sábio, admirado pelo próprio presidente dos EUA, que cogita escolher o ingênuo Chance como seu sucessor.

Papagaios estocásticos — repetidores baseados em probabilidade. Foi assim que, em 2021, as linguistas computacionais Emily Bender e Angelina McMillan-Major, e as cientistas da computação Timnit Gebru e Margaret Mitchell descreveram as LLMs (sigla em inglês para os modelos de linguagem largos), a tecnologia de inteligência artificial por trás dos chatbots como ChatGPT. Eis a explicação longa:

Ao contrário do que parece ao observador de sua produção, um modelo de linguagem é um sistema que costura aleatoriamente sequências de formas linguísticas que ele observa no enorme grupo de dados que lhe serviu de treinamento, de acordo com informação probabilística sobre como esses dados se combinam, mas sem qualquer referência sobre o que significam.

O jogo da imitação era uma brincadeira em que um interrogador tentava adivinhar quem era a mulher entre dois respondentes ocultos a ele. O polímata britânico Alan Turing se baseou nesse jogo para propor um teste de performance para inteligência artificial (IA) em 1950: no lugar de uma das pessoas, uma IA. Assim, o objetivo não é ser, mas parecer humano. Turing passava por cima do conceito de inteligência por ser de difícil descrição.

Um anos antes, o neurocirurgião Geoffrey Jefferson propunha um patamar mais elevado para testar a evolução da IA: “Só quando uma máquina conseguir escrever um soneto ou um concerto graças aos seus próprios pensamentos e emoções, e não por um acidente fortuito dos símbolos, poderemos concordar que a máquina se iguala ao cérebro — isto é, não só ter criado mas saber que o criou.”

Assim como “comunismo” e “fascismo”, duas pessoas podem discutir sobre inteligência artificial sem estarem falando sobre a mesma coisa. Pode-se até definir IA, grosso modo, como aquela tecnologia que consegue processar informação e realizar atividades assim como os humanos. Se paramos aí, dá para dizer que ela já existe. Porém, a palavra “inteligência” vem do latim intellegentia (discernimento, compreensão, e até mesmo gosto), originária da fusão de inter (entre) e legere (ler, escolher). Escolhas e decisões ficam limitadas se quem decide não tem consciência de que tem todas as informações necessárias para preencher as lacunas ou improvisar; é preciso ter um gosto da realidade para conseguir lidar com ela. Neste caso, se a inteligência artificial é aquela que faz coisas “como os humanos”, ela deve possuir senciência.

Até hoje, filósofos e cientistas se batem e debatem sobre o que é senciência. O certo é que a IA atual não a possui.

A frase “inteligência artificial” apareceu pela primeira vez com seu uso atual num pedido de fundos para um projeto de pesquisa de dois meses comandado pelo cientista cognitivo e matemático John McCarthy, em Dartmouth College (EUA), 1955. Outros membros do grupo preferiam nomes como “processamento de informação complexa”. Na mesma época, especialistas rebatizavam sua área de estudos de “modelos cerebrais” para “o problema da inteligência artificial”. Finalmente, até o “problema” sumiu; já o problema, continuou.

Quando os pioneiros da inteligência artificial começaram a se debruçar sobre o tema, dois caminhos de pesquisa se consolidaram: o simbólico, que se dedicaria a ensinar regras para a IA raciocinar, como um cérebro humano (GOFAI, sigla em inglês para “boa e velha IA”); e as redes neurais, que aprenderiam somente do treinamento com quantidades cada vez maiores de dados. O segundo caminho, como um concurseiro decoreba, é o dominante atualmente, e seu resultado mais vistoso são os LLMs. Se a GOFAI é muito mais difícil, as redes neurais mostram sinais de esgotamento.

Foi marketing. GenAI (sigla em inglês para inteligência artificial geradora) nasceu em 2007 numa apresentação de um pesquisador da Google, Shane Legg, para tentar promover um campo de pesquisa que, 50 anos depois de McCarthy e sua turma, estava em baixa. “Eu não tinha em mente uma definição clara”, Legg diria mais tarde. Hoje, a palavra é usada para se referir aos LLMs e ao ChatGPT indiscriminadamente.

O que a imprensa chama hoje de IA não se resume aos LLMs, daí a confusão. Algoritmos são IA, o corretor ortográfico do celular é IA, o sistema de verificação de pedidos de benefícios do INSS usa um tipo de IA, e por aí vai.

Ninguém sabe exatamente como as redes neurais chegam aos resultados que entregam ao usuário, nem mesmo os que trabalham com ela. Este parece ser um problema de todos os sistemas tecnológicos modernos, de foguetes ao iPad. “Parece mágica para mim”, disse Sam Altman, o presidente da OpenAi, empresa do ChatGPT.

Antigamente, a matemática era mágica, imbuída de todo significado filosófico ou mitológico pelos gregos. O misticismo em torno dos números só cresceria nos séculos seguintes. No período dos Tudor e dos Stuart na Grã-Bretanha, livros de matemática acabaram na fogueira como evidência de feitiçaria.

Em 2024, a Organização Rand entrevistou 65 cientistas para entender porque a maioria dos modelos de IA fracassam. Encontrou cinco motivos principais: os líderes da área não entendem quais problemas precisam ser solucionados, falta de dados, ânsia de lucrar com as últimas atualizações, infraestrutura inadequada, e emprego da tecnologia para resolver “problemas muito complexos para a IA”. Esse último problema acontece muito porque o bicho volta e meia se enrola e alucina.

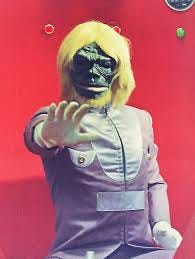

Separados na semiótica: Linda Yaccarino, a CEO da rede social XTwitter de Elon Musk, em vídeo onde avisa que vai processar anunciantes boicotando sua plataforma, e o Dr. Gori, vilão extraterrestre que cria monstros gigantes para acabar com a humanidade no seriado Spectreman (1971-72).

Os LLMs consomem água, muita água, num planeta que já enfrenta sérios problemas de escassez. Uma busca tradicional no Google (antes da IA) gastava meio mililitro de água em energia. O ChatGPT gasta meio litro de água para cada 5 a 50 vezes que é acionado pelos usuários (prompts).

A água é necessária para resfriar os servidores e bancos de dados que treinam e fazem os LLMs funcionar. Quanto mais poderoso o LLM, mais água. Em vários lugares do mundo, especialmente onde água é quase luxo, surgem conflitos com populações locais.

Obviamente, os militares estão animados com as IAs, da mesma forma como ficam animados com qualquer novidade tecnológica, sejam projetos de aviões que bebem dinheiro, programas de defesa que são bombas-relógios de dívidas, integração homem-máquina boa na teoria, ou submarinos nucleares que não saem do estaleiro. O Exército Israelense usou o sistema de IA Lavender para matar oficiais do Hamas em Gaza por meio de mísseis com o mínimo de interferência de oficiais humanos, para lavar as mãos de responsabilidades, e com grande tolerância ao assassinato de civis. Além disso, o Lavender confunde alvos simplesmente por possuírem métodos de comunicação e nomes semelhantes aos de alvos legítimos. Nesse mesmo período, um general da Força Aérea dos EUA disse que não haveria perigo de uso de IA pelos militares ocidentais e seus aliados porque estas sociedades se guiam por profundos valores judaico-cristãos.

O reconhecimento facial utilizado por diversos departamentos policiais não funciona para combater a criminalidade, é tendencioso, torna milhares de dados vulneráveis, e prende inocentes.

As empresas usam trabalhadores precários com salários muito baixos em países menos desenvolvidos para treinar seus algoritmos e suas LLMs. No Brasil, a Meta (Facebook) paga cerca de 18 reais por hora para que moderadores de conteúdo avaliem postagens — incluindo todo tipo de violência — que alimentarão a IA. Trabalhadores do Quênia fazem o mesmo tipo de trabalho por cerca de 10 reais a hora.

Segundos de sabedoria

Caiu na rede, é comida de IA.

No cinema de 1983, uma inteligência artificial quase destrói o mundo por vontade própria no suspense Jogos de Guerra (John Badham, 1983). A partir de um jogo de estratégia com um hacker (Matthew Broderick), um supercomputador quase ganha controle sobre as armas nucleares dos EUA.

Na vida real de 1983, um supercomputador quase destrói o mundo por mal funcionamento. O sistema de defesa soviético havia confundido clarões solares em nuvens com mísseis de um ataque norte-americano. Coube ao tentente-coronel Stanislav Petrov quebrar o protocolo de procedimento, verificar a não-existência dos tais mísseis em outros satélites, e evitar um inverno nuclear.

As IAs, atualmente, costumam funcionar para tarefas administrativas corriqueiras ou ajudando cientistas a compilar milhares de dados para criar modelos de análise científica mais abrangentes:

A IA oferece ótimas ferramentas de resumo de reuniões. Uma dessas esta disponível pelo Zoom, mas há outras que você pode carregar por aí, como gravadores com ChatGPT embutido.

Ajuda a criar centenas de simulações com rapidez para se prever a formação de fenômenos climáticos.

Identifica milhares de diferenças estruturais em moléculas que podem levar a diferentes odores.

Auxilia pessoas com deficiência nas tarefas do dia-a-dia.

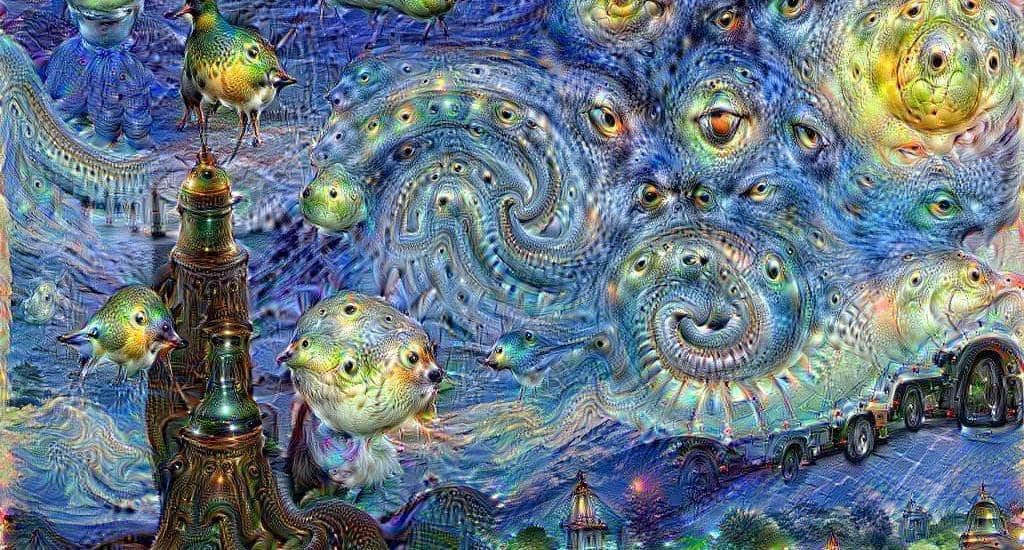

O mundo surreal da artista Niceaunties, criado com o auxílio de IA.

Em janeiro de 2024, o presidente da OpenAI admitiu que seria “impossível” treinar LLMs sem atropelar direitos autorais de escritores, artistas, e do cachorro da esquina, em suma, sem pirataria.

Meses depois, ignorando a declaração acima, os estúdios de cinema anunciavam que haviam fechado um grande site pirata de filmes e respiravam aliviados. Em vão.

Artigos científicos escritos pelo ChatGPT e sem nenhum rigor começam a poluir o mecanismo de busca Google Scholar, gerando volume de citações em outros artigos e colocando repositórios científicos — e a própria ciência — em risco.

O Projeto de Semáforo por IA da Google é um exemplo dos limites dos algoritmos. Geralmente, os sistemas de tráfego são uma mistura de computadores e supervisão humana para lidar com imprevistos, e há muitos imprevistos no trânsito. Nenhum algoritmo pode dar conta de coisas que ele não sabe. Engenheiros de tráfego das cidades que adotaram o programa criticaram a qualidade de suas recomendações. A IA não levava em conta pedestres, rotas de ônibus nem a invasão de zonas residenciais. O objetivo do projeto era diminuir emissões de carbono no trânsito, mas ele ainda está longe de alcançá-lo. E quando o alcançar, fará melhor e mais barato que um humano?

Ainda é possível identificar as deepfakes, aquelas imagens e vídeos falsos de gente de verdade, investigando as janelas da alma, os olhos. Com ferramentas astronômicas que permitem ver a distribuição da luz em imagens, pesquisadores de IA da Universidade de Hull (Inglaterra) conseguiram desmascarar 70% das imagens artificiais testadas.

Como detectar escrita de trabalho de aluno feita por IA? Familiarizando-se com o estilo do aluno. Ou mudando a avaliação para sabatinas orais e tarefas de classe.

Quer uma comidinha gostosa, aromática, e vistosa? Não peça a uma IA, já que paladar e cheiro — e a memória desses sentidos que os grandes cozinheiros possuem — são algo que os criadores de algoritmos somente sonham em emular.

Atualmente, empreendimentos de IA com LLMs não são economicamente sustentáveis. A Sequoia Capital calculou que precisariam lucrar 600 bilhões de dólares para pagar o que é investido — hoje há um rombo de 500 bilhões. A empresa que mais fatura com o filão, a OpenAI, do ChatGPT e do gerador de imagens Dall-E, não passa dos 3,4 bilhões anuais de lucro (contra 5 bi de prejuízo). Essa mesma OpenAI busca um aporte de 100 bilhões, o que prova sua vulnerabilidade. Relatório a investidores da Elliott Management descreveu a LLM como “superestimada” e avaliou que seus supostos usos “nunca serão eficientes no nível do custo-benefício, nunca funcionarão adequadamente, gastarão muita energia, e não serão confiáveis”. A queda vertiginosa do valor das ações de empresas de tecnologia no fim de julho de 2024 reflete temor de uma bolha. No início de agosto, a Berkshire Hathaway de Warren Buffett livrou-se de metade das ações da Apple, que anunciara uma parceria com a… OpenAI.

Os empresários e investidores que movem esta onda de IA tiram a sua visão de mundo de um universo limitado: a ficção científica e a fantasia do século XX. Sua compreensão do que leram tampouco parece mais larga. Sam Altman, da OpenAI, vende seu ChatGPT com alertas tirados de O Exterminador do Futuro, cuja IA é fruto de uma poderosa empresa como a dele. Jeff Bezos, da Amazon, é fã do universo da Cultura de Iain Banks, um socialista que esculhambava a interpretação pró-mercado que certas pessoas faziam de seus livros. O influente libertário Peter Thiel, investidor da Cognition Labs, batiza os seus empreendimentos com nomes tirados de O Senhor dos Anéis, uma obra que alerta sobre a corrupção inerente ao poder.

O sul-africano supremacista Elon Musk, dono da xAI, é fascinado pelo Guia do Mochileiro das Galáxias, de Douglas Adams, escritor que tinha um adesivo “Acabem com o apartheid” em sua máquina de escrever. Musk se inspirou na obra para batizar um de seus filhos (Y) e o robô de IA da rede social XTwitter (Grok). A história de Adams é uma sátira implacável a “mercadores ricos” como Musk.

Em 1979, uma repórter foi às portas dos cinemas em Fort Worth, Texas, para perguntar ao público por que estavam levando seus filhos muito jovens à estreia de Alien - O Oitavo Passageiro, filme sobre um alienígena parasitário que aterroriza a tripulação de uma nave espacial. Um dos entrevistados respondeu: “Eu achei que ele tinha que ver porque há coisas assim que podem acontecer na vida real, que podem ser uma história verdadeira baseada na ciência. Nunca se sabe o que pode acontecer do lado de fora do mundo.”

A vida não é ilógica, porém é uma armadilha para os lógicos. Ela aparenta ser um pouco mais matemática e regular do que realmente é.

O escritor britânico G.K. Chesterton em seu ensaio Ortodoxia (1908).

É muito fácil fazer o ChatGPT emitir frases do tipo “Estou feliz em te ver”. Há muitas coisas que não entendemos sobre o funcionamento dos modelos largos de linguagem, mas uma coisa é certa: o ChatGPT não está feliz em te ver.

O escritor Ted Chiang, avaliando a possibilidade de uma dessas inteligências artificiais se comunicar.

Não prestem atenção no homem atrás da cortina.

O Mágico (Frank Morgan), ao ser desmascarado pelo cachorro Totó, em O Mágico de Oz (Victor Fleming, 1939). Roteiro de Noel Langley, Florence Ryerson, e Edgar Allan Woolf a partir do romance de L. Frank Baum.

A causa nº1 da morte de startups é a criação de coisas que ninguém quer.

Paul Graham, sócio da empresa incubadora Y Combinator, que demitiu Sam Altman ao descobrir que o rapaz não era lá muito ético nem pelos padrões de Wall Street. Hoje, Altman é o chefe da OpenAI.